Bot Serviceの.NET SDKであるDialogからQnAMakerを呼びたい場合

Bot Serviceの.NET SDKを使ってQnAMakerを呼び出す基本的な方法は、GitHubにあるサンプルのように、MessageControllerからQnAMakerDialogを継承したクラス、例えばQnADialogを以下のように呼び出すやり方になります。

public async Task<HttpResponseMessage> Post([FromBody]Activity activity)

{

if (activity.Type == ActivityTypes.Message)

{

await Conversation.SendAsync(activity, () => new Dialogs.QnADialog());

}

......ですが、いきなりFAQに行くのではなく、Botでの会話フローの中でQnAMakerを呼び出したいですよね。つまり、MessageControllerからRootDialogを呼び出し、その中でQnAMakerを呼び出したいということになります。

通常、ダイアログから別のダイアログを呼び出す場合は、マニュアルに記述されているようにIDialogContext .Forwardを使って別のダイアログの呼び出しを行います。

Manage conversation flow with dialogs - Bot Service | Microsoft Docs

IDialogContext .Forwardは別ダイアログのStartAsyncメソッドを呼び出すのですが、QnAMakerDialogに対してはうまく動かず(StartAsyncを使っていない?)、ダイアログ呼び出し後の処理に移ってしまうようです。

QnAMakerのREST APIを直接呼び出すことで対応できるのですが、.NET SDKを使った場合の対応方法については継続して調査しようと思っています。

Azure Machine Learning WorkbenchからSparkクラスタを使う場合の注意点

最近リリースされたAzure Machine Learning Workbenchは、機械学習の実行環境を

- ローカルPC

- ローカルPC上のDocker

- Azure HDInsightのSparkクラスタ

から選択できます。

リモートPCのDocker及びAzure HDInsightのSparkクラスタを使う際の設定方法については

Azure ML のコンピューティング ターゲットとして DSVM と HDI を作成する方法 | Microsoft Docs

に記述されているのですが、追加の設定が必要になる場合があります。

上記のドキュメントに記載されている設定手順は

になります。例えばクラスタ名がmksparkcluster01の場合には、Azure Machine Learning Workbenchからコマンドプロンプトを開き(FileメニューからOpen Command Promptメニューを選択)、以下のコマンドを実行すると、Sparkクラスタにアタッチできます。

az ml computetarget attach --name mksparkcluster01 --address mksparkcluster01.azurehdinsight.net --username <ssh username> --password <ssh password> --type cluster az ml experiment prepare -c mksparkcluster01

ただし、これで機械学習のスクリプトを記述して実行すると、以下のエラーが発生することがあります。

ImportError: libmpi_cxx.so.1: cannot open shared object file: No such file or directory

この問題は、MMLSpark (Microsoft Machine Learning Library for Apache Spark) を明示的にSparkクラスタにインストールすることで解消されます (プロジェクトフォルダ配下のaml_config/spark_dependencies.ymlに記述された構成に従ってMMLSparkはインストールされるはずなのですが。。)。

MMLSparkのインストール方法は以下になります。

Azureポータルで作成したHDInsightクラスタを選択し、「スクリプト操作」メニューを選択

「新規で送信」ボタンをクリックし、スクリプト操作として以下を入力します。

- スクリプトの種類:カスタム

- 名前:(適切な名前を入力、例えばMMLSparkInstall)

- ノードの種類:「ヘッド」と「ワーカー」を選択

「作成」ボタンをクリックすると、ヘッドノードとワーカーノードに、MMLSparkがインストールされます。

最新のスクリプトは以下のGitHubで確認してください。

github.com

Cognitive Toolkitを使ってみる ~ 深層学習を数値データの二値分類から初めてみよう

深層学習の入門としては、画像識別アルゴリズム実験用の画像データセットとして公開されているMNISTデータセット(http://yann.lecun.com/exdb/mnist/)を使った画像識別が、いわゆるプログラミング言語のHello Worldに相当するものとされています。

ただし、二次元数値データの二値分類を深層学習で行い、その動作を確認してみることは、深層学習を始めるうえでのより簡単な一歩になると思います。深層学習の最初の一歩をここから始め、その後に画像識別や言語識別のような、より深層学習の力が発揮できる領域に入ってみてはいかがでしょうか。

ここでは深層学習の最初の一歩として、Microsoft Cognitive ToolkitのPython APIを使った順伝播型ネットワーク(feed forward network)による二値分類のチュートリアルを実行してみます。使用するチュートリアルは以下になります。

CNTK 102: Feed Forward Network with Simulated Data:

https://github.com/Microsoft/CNTK/blob/v2.0.rc2/Tutorials/CNTK_102_FeedForward.ipynb

シナリオ

被験者の年齢と腫瘍の大きさから、良性腫瘍と悪性腫瘍を深層学習にて分類します。データはプログラムで生成したシミュレーションデータとします。

必要なモジュールのインポート

以下のモジュールをインポートしておきます。なお、「%matplotlib inline」はJupyter Notebookを使用する場合にのみ必要です。

from __future__ import print_function import matplotlib.pyplot as plt %matplotlib inline import numpy as np import sys import os import cntk as C from cntk import Trainer, learning_rate_schedule, UnitType, sgd from cntk.initializer import glorot_uniform from cntk.layers import default_options, Dense

デバイスの設定

プログラムを実行するデバイス(CPUもしくはGPU)を指定します。オプションとして、GPUをロックすることもできます(デフォルトはOFFです)。

if 'TEST_DEVICE' in os.environ:

import cntk

if os.environ['TEST_DEVICE'] == 'cpu':

cntk.device.try_set_default_device(cntk.device.cpu())

else:

cntk.device.try_set_default_device(cntk.device.gpu(0))

シミュレーションデータの生成

二次元データの二値分類を行うため、特徴数(input_dim)として2、ラベル数(num_output_classes)として2を指定します。なお、同じ乱数を発生するようにseedを固定します。

np.random.seed(0) input_dim = 2 num_output_classes = 2

シミュレーションデータを生成する関数を定義します。

def generate_random_data_sample(sample_size, feature_dim, num_classes):

Y = np.random.randint(size=(sample_size, 1), low=0, high=num_classes)

X = (np.random.randn(sample_size, feature_dim)+3) * (Y+1)

X = X.astype(np.float32)

class_ind = [Y==class_number for class_number in range(num_classes)]

Y = np.asarray(np.hstack(class_ind), dtype=np.float32)

return X, Y

サンプル数を64として、シミュレーションデータを生成します。

mysamplesize = 64 features, labels = generate_random_data_sample(mysamplesize, input_dim, num_output_classes)

シミュレーションデータを可視化します。X軸を被験者の年齢、Y軸を腫瘍の大きさとし、悪性腫瘍を赤点、良性腫瘍を青点としています。

colors = ['r' if l == 0 else 'b' for l in labels[:,0]]

plt.scatter(features[:,0], features[:,1], c=colors)

plt.xlabel("Scaled age (in yrs)")

plt.ylabel("Tumor size (in cm)")

plt.show()

ここまでのプログラムを実行すると、以下のようなグラフが表示されます。

このプログラムにより、どのようなシミュレーションデータが生成されるかが把握できるかと思います。

順伝播型ネットワークモデルの作成

このチュートリアルでは、フルコネクトの順伝播型ネットワークを使用します。フルコネクトとは、下図のようにすべての隣接層のノードが接続された(つまり、前層のすべてのノードが次層の各ノードの入力になる)ネットワークのことであり、順伝播型とは情報が入力側から出力側に一方向にのみ伝播するネットワークのことです。

隠れ層の数(num_hidden_layers)を2、各隠れ層のノード数(hidden_layers_dim)を50とします。

num_hidden_layers = 2 hidden_layers_dim = 50

ネットワークへの入力変数(特徴やラベル)を定義します。Cognitive Toolkitでは、モデルの訓練やモデルのテストで使用する様々な観測値を、ネットワークへの入力変数に格納します。したがって、入力変数の次元は使用する訓練データの次元と一致します。訓練データは「被験者の年齢」と「腫瘍の大きさ」という次元を持つため、次元数は2になります。

input = C.input(input_dim) label = C.input(num_output_classes)

ここからは順伝播型のニューラルネットワークモデルを作成していきます。

順伝播型ネットワークでは、n+1番目の層のノードの出力はn番目の層のノードの出力

から

で計算されます。ここで、は重み、

はバイアス、

は活性化関数です。活性化関数としてはシグモイド関数や双曲線正接関数がよく使われます。

活性化関数としてシグモイド関数を使った場合、最終的な出力はとして

def linear_layer(input_var, output_dim):

input_dim = input_var.shape[0]

weight = C.parameter(shape=(input_dim, output_dim))

bias = C.parameter(shape=(output_dim))

return bias + C.times(input_var, weight)

として

def dense_layer(input_var, output_dim, nonlinearity):

l = linear_layer(input_var, output_dim)

return nonlinearity(l)

とすることにより、

def fully_connected_classifier_net(input_var, num_output_classes, hidden_layer_dim,

num_hidden_layers, nonlinearity):

h = dense_layer(input_var, hidden_layer_dim, nonlinearity)

for i in range(1, num_hidden_layers):

h = dense_layer(h, hidden_layer_dim, nonlinearity)

return linear_layer(h, num_output_classes)

z = fully_connected_classifier_net(input, num_output_classes, hidden_layers_dim,

num_hidden_layers, C.sigmoid)

と記述できます。

このネットワークモデルは、Cognitive ToolkitのLayer Libraryを使うと、以下のように、より簡単に記述できます。

def create_model(features):

with default_options(init=glorot_uniform(), activation=C.sigmoid):

h = features

for _ in range(num_hidden_layers):

h = Dense(hidden_layers_dim)(h)

last_layer = Dense(num_output_classes, activation = None)

return last_layer(h)

z = create_model(input)

ここでは、デフォルトのオプションで、重みとバイアスのイニシャライザとしてGlorotイニシャライザ(fanIn+fanOutでスケーリングした一様分布)を指定し、活性化関数としてシグモイド関数を指定しています。

ネットワークモデルの訓練の準備

順伝播型ネットワークモデルの訓練では、交差エントロピーを誤差関数とし、重みとバイアス

に対して最小化させます。

交差エントロピーは、最終層の出力に対してソフトマックス関数で予測確率を

と定義することで、以下のように計算できます。

ここで、はラベルの次元数、

はラベルを表しています。

Cognitive Toolkitは交差エントロピーを計算するパッケージを持っているため、ネットワークの出力と訓練データのラベルを引数にして記述できます。

loss = C.cross_entropy_with_softmax(z, label)

同じく、ネットワークの出力に対する誤差も、ネットワークの出力と訓練データのラベルを引数にして記述できます。

eval_error = C.classification_error(z, label)

確率的勾配降下法(SGD: Stochastic Gradient Descent)は誤算関数を最小化させる最も一般的な手法です。ここではSGDを使用して、ネットワークモデルの訓練を行います。確率的勾配降下法では、重みとバイアスの初期値(ここではGlorotイニシャライザにより初期化)から始め、訓練データごとに予測されたラベル値と正しいラベル値に対する誤差関数を評価し、重みとバイアスの値を調整する処理を繰り返します。

このチュートリアルでは、個々の訓練データに対してではなく、より計算効率を高めるために、訓練データを特定のサンプル数でまとめたミニバッチに対してSGDを適用します。

SGDにおける重要なパラメータとして、学習率があります。これは誤差関数を最小化させる(数学的には極小解に収束させるという言い方をします)ために重要なパラメータです。この値が大きいとうまく収束できず、小さいと適切な極小解に収束できない、もしくは収束が遅くなるという性質を持つため、この値の調整は非常に重要です。

このチュートリアルでは0.5という値においています。

learning_rate = 0.5

Cognitive Toolkitでは、SGDを使った訓練オブジェクトを作成し、そのオブジェクトに対して訓練データを投入します。訓練オブジェクトは以下のように記述できます。

lr_schedule = C.learning_rate_schedule(learning_rate, UnitType.minibatch) learner = C.sgd(z.parameters, lr_schedule) trainer = Trainer(z, (loss, eval_error), [learner])

その他、訓練の結果を可視化するために役立つ関数として、移動平均を計算する関数と、訓練の進捗を出力する関数を定義しておきます。

def moving_average(a, w=10):

if len(a) < w:

return a[:] # Need to send a copy of the array

return [val if idx < w else sum(a[(idx-w):idx])/w for idx, val in enumerate(a)]

def print_training_progress(trainer, mb, frequency, verbose=1):

training_loss = "NA"

eval_error = "NA"

if mb%frequency == 0:

training_loss = trainer.previous_minibatch_loss_average

eval_error = trainer.previous_minibatch_evaluation_average

if verbose:

print ("Minibatch: {}, Train Loss: {}, Train Error: {}".format(mb, training_loss, eval_error))

return mb, training_loss, eval_error

ネットワークモデルの訓練の実行

ミニバッチに含まれる訓練データ数(minibatch_size)、全訓練データ数(num_samples)を定義します。また、処理を行う回数(num_minibatches_to_train)も定義しておきます。

minibatch_size = 25 num_samples = 20000 num_minibatches_to_train = num_samples / minibatch_size

訓練を実行します。訓練データは、ミニバッチの大きさの訓練データを毎回プログラムで生成しています。

training_progress_output_freq = 20

plotdata = {"batchsize":[], "loss":[], "error":[]}

for i in range(0, int(num_minibatches_to_train)):

features, labels = generate_random_data_sample(minibatch_size, input_dim, num_output_classes)

# Specify the input variables mapping in the model to actual minibatch data for training

trainer.train_minibatch({input : features, label : labels})

batchsize, loss, error = print_training_progress(trainer, i,

training_progress_output_freq, verbose=0)

if not (loss == "NA" or error =="NA"):

plotdata["batchsize"].append(batchsize)

plotdata["loss"].append(loss)

plotdata["error"].append(error)

訓練結果の可視化をします。1つ目のグラフでは、X軸を実行したミニバッチの件数、Y軸を誤差関数の値とし、2つ目のグラフではY軸を移動平均の値としています。

plotdata["avgloss"] = moving_average(plotdata["loss"])

plotdata["avgerror"] = moving_average(plotdata["error"])

plt.figure(1)

plt.subplot(211)

plt.plot(plotdata["batchsize"], plotdata["avgloss"], 'b--')

plt.xlabel('Minibatch number')

plt.ylabel('Loss')

plt.title('Minibatch run vs. Training loss')

plt.show()

plt.subplot(212)

plt.plot(plotdata["batchsize"], plotdata["avgerror"], 'r--')

plt.xlabel('Minibatch number')

plt.ylabel('Label Prediction Error')

plt.title('Minibatch run vs. Label Prediction Error')

plt.show()

ここまでのプログラムを実行すると、以下のようなグラフが表示されます。これを見ると、誤差関数、移動平均共に、実行したミニバッチの件数が増えるにしたがって収束していくことが分かるかと思います。

訓練済みネットワークモデルの評価

ネットワークモデルの訓練が完了しましたので、ここではテストデータを使い、訓練済みネットワークモデルを評価します。

テストデータも訓練データと同様に、プログラムで生成したシミュレーションデータとしています。

test_minibatch_size = 25 features, labels = generate_random_data_sample(test_minibatch_size, input_dim, num_output_classes)

訓練済みのネットワークモデルに対して、テストデータを投入します。

trainer.test_minibatch({input : features, label : labels})

ここまでのプログラムを実行すると、テストデータを使用した場合の誤差率が表示されます。

個々のテストデータに対する正誤を確認する場合には、以下のコードを記述して実行します。

out = C.softmax(z)

predicted_label_probs = out.eval({input : features})

print("Label :", [np.argmax(label) for label in labels])

print("Predicted:", [np.argmax(row) for row in predicted_label_probs])

以上で、深層学習による二値分類のチュートリアルが終了しました。このチュートリアルをベースとして、学習率を変更した時の精度の変化や、確率的勾配効果法以外の手法を試してみるのもよいと思います。

Microsoft Translatorを使ったテキスト機械翻訳 -基本編

Microsoft Translatorは機械翻訳のためのSaaS APIです。現在はAzure Cognitive Servicesという人工知能サービスAPI群の一つとして提供されています。

以前はAzure DataMarketというサービスで提供されていましたが、DataMarketは2017年3月31日で提供終了、DataMarketでのMicrosoft Translatorへのアクセスも2017年4月30日で終了します。

このサービスはテキスト翻訳のためのTranslator Text APIと音声翻訳のためのTranslator Speech APIを提供していますが、ここではTranslator Text APIの特徴と基本的な使い方を紹介しようと思います。

特徴

- Bing翻訳やOffice、Skype Translatorにも組み込まれており、アプリケーションとしてすぐ使えるものとしても提供している

- 日本語を含む60言語 (2017年2月) に対応している

- 従来の統計的機械翻訳に加えて、人工知能型といえる深層学習型機械翻訳のアルゴリズムも提供開始 (深層学習型機械翻訳は2017年2月現在は日本語、英語を含む10か国語に対応していますが、今後増える予定です)

統計的機械翻訳は辞書登録だけで翻訳品質を上げることは難しく、対訳文 (日本語の文章と英語の文章のペアのような) で学習させることが必要と言われていますが、深層学習型機械翻訳は統計的機械翻訳よりもはるかに高い翻訳品質を実現するものとして期待されています。

まずは試してみる

Microsoft Translatorを簡単に試してみるには、Bing翻訳を使うのがてっとり早いです。「category」GETパラメータで「generalnn」と指定するだけで、アルゴリズムが切り替わります。

例としてMicrosoft Translatorの製品ページにある以下の文章を訳してみます。

Microsoft Translator Text API, part of the Microsoft Cognitive Services API collection, is a cloud-based machine translation service supporting multiple languages that reach more than 95% of world's gross domestic product (GDP). Translator can be used to build applications, websites, tools, or any solution requiring multilanguage support.

統計的機械翻訳の場合:

Microsoft Translator テキスト API、Microsoft 認知サービス API コレクションの一部は、世界の国内総生産 (GDP) の 95% 以上に達する複数の言語のサポート クラウド ベースの機械翻訳サービスです。アプリケーション、web サイト、ツール、または複数言語のサポートを必要とする任意のソリューションを構築するトランスレーターを使用することができます。

個人目的として使う分にはよさそうですが、正式文書で使うには学習したほうがよさそうです。

深層学習型機械翻訳の場合:

microsoft 認知サービス api コレクションの一部である Microsoft Translator テキスト api は、世界の国内総生産 (gdp) の 95% 以上に達する複数の言語をサポートするクラウドベースの機械翻訳サービスです。トランスレータは、アプリケーション、web サイト、ツール、または多言語サポートを必要とする任意のソリューションを構築するために使用できます

自然な文書になってますね。アルゴリズムを変えるだけで、ここまで訳に変化が出ています。

Translator Text APIを使ってみる

それでは本題であるTranslator Text APIの使い方を紹介していきます。Translator Text APIでもアルゴリズムの変更は簡単にできますので、合わせて紹介していきます。

なお、Translator Text APIにはREST、SOAP、AJAXの3つの種類のAPIがありますが、ここではREST APIを使用します。

Translator Text APIを使用するには、以下の3つの手順が必要になります。

- Subscription Keyの取得

- 認証サービスの呼出

- 認証サービスを呼び出し、Subscription Keyから認証トークンを生成します。

- 翻訳サービスの呼出

- 認証サービスを呼び出し、文章を翻訳します。

以下では、これらの基本的な使用方法について記述していきます。

Subscription Keyの取得

まずはAzureが使用できるようにしてください。こちらについては各種情報があると思いますので、そちらをご参考に。

Azureポータルにログインしたら、左のメニューから「新規」→「Intelligence + analytics」→「Cognitive Services APIs」を選択します。

Cognitive Servicesアカウントの作成画面で、以下の項目を入力し、アカウントを作成します。

- Account name:アカウントの表示名を入力

- サブスクリプション:利用可能なサブスクリプションを選択

- API Type:Translator Text API

- 価格レベル:任意の価格レベル(F0を選択すると、200万文字まで利用可能な無料版となります)

- Resource Group:任意で作成もしくは既存のリソースグループを選択

- Resource group location:自分のいる場所に近いロケーションを選択

アカウントが作成されたら、作成したアカウントを選択し、「Keys」メニューを選択して「KEY 1」を確認します。こちらがSubscription Keyになりますので、記録しておいてください。

Subscription Keyの取得方法については、以下のドキュメントを参考にしてください。

https://www.microsoft.com/ja-jp/translator/getstarted.aspx

認証サービスの呼出

Translator Text APIの呼出は、認証トークンによる認証が必要です。認証トークンは複数の認証サービスの呼出に対して再利用できますが、有効時間は10分となっているため、認証サービスを呼び出す際には有効時間を考慮する必要があります。

認証トークンは、認証サービスに対して「Ocp-Apim-Subscription-Key」ヘッダーにSubscription Keyをセットしてリクエストするか、「Subscription-Key」GETパラメータにSubscription Keyをセットしてリクエストすることで取得できます。認証サービスのURLは以下になります。

認証サービス:https://api.cognitive.microsoft.com/sts/v1.0/issueToken

翻訳サービスの呼出時には、認証トークンをBearトークンとしてヘッダーにセットして渡します。

以下のコードは、認証サービスを呼び出すためのC#のサンプルクラスになります。

public class AzureAuthToken

{

// 認証サービスのURL

private static readonly Uri ServiceUrl = new Uri("https://api.cognitive.microsoft.com/sts/v1.0/issueToken");

// Subscription Keyを渡すときの要求ヘッダー

private const string OcpApimSubscriptionKeyHeader = "Ocp-Apim-Subscription-Key";

// 認証トークンの有効時間:5分

private static readonly TimeSpan TokenCacheDuration = new TimeSpan(0, 5, 0);

// 有効な認証トークンを格納

private string storedTokenValue = string.Empty;

// 有効な認証トークンの取得時間

private DateTime storedTokenTime = DateTime.MinValue;

/*

Subscription Keyの取得

*/

public string SubscriptionKey { get; private set; } = string.Empty;

/*

認証サービスへのリクエスト時のHTTPステータスコードの取得

*/

public HttpStatusCode RequestStatusCode { get; private set; }

/*

認証トークンを取得するためのクライアント作成

<param name="key">Subscription Key</param>

*/

public AzureAuthToken(string key)

{

if (string.IsNullOrEmpty(key))

{

throw new ArgumentNullException("key", "Subscription Keyが必要です。");

}

this.SubscriptionKey = key;

this.RequestStatusCode = HttpStatusCode.InternalServerError;

}

/*

Subscriptionに紐づいた認証トークンの取得 (非同期)

*/

public async Task<string> GetAccessTokenAsync()

{

if (SubscriptionKey == string.Empty) return string.Empty;

// 認証トークンが有効な場合は有効な認証トークンを返す

if ((DateTime.Now - storedTokenTime) < TokenCacheDuration)

{

return storedTokenValue;

}

// 認証トークンを取得

using (var client = new HttpClient())

using (var request = new HttpRequestMessage())

{

request.Method = HttpMethod.Post;

request.RequestUri = ServiceUrl;

request.Content = new StringContent(string.Empty);

request.Headers.TryAddWithoutValidation(OcpApimSubscriptionKeyHeader, this.SubscriptionKey);

client.Timeout = TimeSpan.FromSeconds(2);

var response = await client.SendAsync(request);

this.RequestStatusCode = response.StatusCode;

response.EnsureSuccessStatusCode();

var token = await response.Content.ReadAsStringAsync();

storedTokenTime = DateTime.Now;

storedTokenValue = "Bearer " + token;

return storedTokenValue;

}

}

/*

Subscriptionに紐づいた認証トークンの取得 (同期)

*/

public string GetAccessToken()

{

// 認証トークンが有効な場合は有効な認証トークンを返す

if ((DateTime.Now - storedTokenTime) < TokenCacheDuration)

{

return storedTokenValue;

}

// 認証トークンを取得

string accessToken = null;

var task = Task.Run(async () =>

{

accessToken = await GetAccessTokenAsync();

});

while (!task.IsCompleted)

{

System.Threading.Thread.Yield();

}

if (task.IsFaulted)

{

throw task.Exception;

}

else if (task.IsCanceled)

{

throw new Exception("トークンの取得がタイムアウトしました。");

}

return accessToken;

}

}

認証サービスの使用方法については、以下のドキュメントを参考にしてください。

http://docs.microsofttranslator.com/oauth-token.html

翻訳サービスの呼出

翻訳サービスは

http://api.microsofttranslator.com/v2/Http.svc/

こちらのURLで提供されています。複数のサービスが使用できますが、最も単純な翻訳サービスは以下になります。

http://api.microsofttranslator.com/v2/http.svc/translate

このサービスに対して以下のGETパラメータを指定してリクエストすることで、翻訳が実行されます。

- text

- 翻訳対象文書

- appId

- from

- 翻訳元言語

- to

- 翻訳先言語

- category

以下のコードは、翻訳サービスを呼び出すためのC#のサンプルクラスになります。

public class CallTranslator

{

// Subscription Key

private const string SubscriptionKey = "<Subscription Keyを入力>";

// TranslateサービスのURL

private static readonly Uri ServiceUrl = new Uri("http://api.microsofttranslator.com/v2/Http.svc/");

/*

翻訳の実施

<param name="textToTransform">翻訳対象文書</param>

<param name="fromLangCode">翻訳元言語</param>

<param name="toLangCode">翻訳先言語</param>

<param name="domain">翻訳ドメイン</param>

*/

public string TranslateMethod(string textToTransform, string fromLangCode, string toLangCode, string domain)

{

// トークンの取得

var authTokenSource = new AzureAuthToken(SubscriptionKey);

var token = string.Empty;

token = authTokenSource.GetAccessToken();

// 翻訳サービスの呼出

string uri = ServiceUrl + "Translate?text=" + System.Web.HttpUtility.UrlEncode(textToTransform)

+ "&appid=" + token + "&from=" + fromLangCode + "&to=" + toLangCode + "&category=" + domain;

HttpWebRequest httpWebRequest = (HttpWebRequest)WebRequest.Create(uri);

WebResponse response = null;

string translatedText = null;

try

{

response = httpWebRequest.GetResponse();

using (Stream stream = response.GetResponseStream())

{

System.Runtime.Serialization.DataContractSerializer dcs = new System.Runtime.Serialization.DataContractSerializer(Type.GetType("System.String"));

translatedText = (string)dcs.ReadObject(stream);

}

} catch (Exception ex){

Console.WriteLine("message: " + ex.Message);

Console.WriteLine("stack trace: ");

Console.WriteLine(ex.StackTrace);

Console.ReadLine();

}

return translatedText;

}

翻訳サービスの使用方法については、以下のドキュメントを参考にしてください。こちらではその他のサービスの使用方法についても記載されています。

http://docs.microsofttranslator.com/text-translate.html#!/default/get_Translate

上記のコードを使用したサンプルコードをGitHubで公開していますので、そちらも参考にしてみてください。サンプルコードでは、翻訳対象文書から翻訳元言語を自動識別するサービスも使っています。

https://github.com/masakykato0526/SimpleMicrosoftTranslator

私訳:NumPy Quickstart tutorial

Pythonの数学計算ライブラリであるNumPyは深層学習を含めた機械学習に必須のライブラリですが、日本語情報があまり多くないため、Quickstart tutorialを翻訳してみました。

あくまで私訳ですので、原文と合わせてみて頂ければと思います。

原文:

https://docs.scipy.org/doc/numpy-dev/user/quickstart.html

前提

このチュートリアルを読む前に、Pythonについてある程度知っておいたほうがよいです。記憶を蘇らせたいのであれば、Python tutorial を参照してください。

このチュートリアルのサンプルを実行したい場合は、自分のコンピューターにソフトウエアをインストールしておく必要があります。手順については、http://scipy.org/install.htmlを参照してください。

基礎

NumPy の主要なオブジェクトは、同次の多次元配列です。これは(通常は数字の)要素のテーブルであり、全て同じ型、正の整数のタプルでインデックス付けされています。NumPyでは、次元は軸、軸の数はランクと呼ばれます。

例えば、三次元空間における点の座標「[1, 2, 1]」は、軸が1つであるためランク1の配列になります。軸の長さは3になります。以下の図の例では、配列はランク2 (2次元) となります。最初の次元 (軸) の長さは2、2つ目の次元の長さは3になります。

NumPyの配列クラスは「ndarray」と呼ばれています。これは「array」というエイリアスとしても知られています。標準のPythonライブラリの「array.array」クラスと同じではないということに注意してください。「array.array」クラスは一次元配列しか扱えませんし、機能も不足しています。「ndarray」クラスの重要な属性を以下に挙げておきます:

ndarray.ndim

配列の軸 (次元) 数です。Pythonの世界では、次元数はランクと呼ばれます。

ndarray.shape

配列に含まれる次元です。これは各次元の配列の大きさを表す整数のタプルになります。n行m列の行列の場合「shape」は「(n,m)」となります。「shape」タプルの長さはランクもしくは次元数である「ndim」の値となります。

ndarray.size

配列に含まれる要素の総数です。これは「shape」の要素の積と等しくなります。

ndarray.dtype

配列に含まれる要素の型を記述するオブジェクトです。dtypeは標準Pythonの型を用いて作成もしくは指定することができます。それに加えて、NumPyはnumpy.int32, numpy.int16, numpy.float64等の独自の型を提供しています。

ndarray.itemsize

配列に含まれる各要素のバイト単位の大きさです。例えば、「float64」型の要素からなる配列では、「itemsize」は8 (=64/8) となり、「complex32」型では4 (=32/8) となります。これはndarray.dtype.itemsizeと同値になります

ndarray.data

配列の実際の要素を収容しているバッファです。配列の要素にはインデックス機能を用いてアクセスするので、通常この属性を使う必要はないでしょう。

例

配列の作成

配列を作成するには、何通りかの方法があります。

例えば、通常のPythonのリストや「array」関数を使用たタプルから配列を作成することができます。作成された配列の型は、シーケンスの要素の型から推定されます。

「array」関数を呼ぶときに、引数として一つの数値のリストを渡すのでなく複数の数値の引数を渡してエラーになるというのは、よくある間違いです。

「array」は、シーケンスのシーケンスを2次元配列に、シーケンスのシーケンスのシーケンスを3次元配列に、といった形で変換します。

配列の作成時に、明示的に型を指定することもできます:

配列の要素が最初は分からず、大きさだけが分かっているということはよくあることです。そのためNumPyは、場所取り用の初期値を入れて配列を作成する関数を提供しています。これにより、コストのかかる演算である配列の拡張の必要性を最小限に抑えられます。

「zeros」関数はすべて0の値を持つ配列を、「ones」関数はすべて1の値を持つ配列を、「empty」はメモリ状態に依存したランダムな初期値を持つ配列を作成します。デフォルトでは、作成された配列のdtypeは「float64」になります。

数値のシーケンスを作成するために、NumPyは、「range」に似た、リストの代わりに配列を返す関数を提供しています。

「arange」が浮動小数点数を引数として使用する場合、浮動小数の精度が有限であるために、一般的には得られる要素数を予測することはできません。このため、stepの代わりに必要な要素数を引数として渡せる「linespace」関数を使うほうが通常望ましいです:

関連項目

array, zeros, zeros_like, ones, ones_like, empty, empty_like, arange, linspace, numpy.random.rand, numpy.random.randn, fromfunction,fromfile

配列の表示

配列を表示する時、NumPyはネストされたリストと同じような方法で表示しますが、以下のレイアウトになります:

- 最後の軸は左から右へ表示されます。

- 最後から2番目の軸は、上から下へ表示されます。

- その他の軸も上から下へ表示されますが、各スライスは空行で区切られます。

したがって、1次元配列は行のように、2次元配列は行列のように、3次元配列は行列のリストのように表示されます。

「reshape」の詳細については、「形状の操作」の項目を参照してください。

配列が大きすぎて表示できない場合には、NumPyは自動的に配列の中心部分を省略して端部分のみ表示します。

この動作を無効にしてNumPyに配列全体を表示させたい場合には、「set_printoptions」を使用して表示オプションを変更することができます。

基本的な演算

配列に対する算術演算は要素ごとに適用されます。新しい配列が作成され、演算結果が入力されます。

多くの行列言語と異なり、NumPyでは乗算演算子「*」は要素ごとの演算を行います。行列の積は「dot」関数もしくはメソッドを使用して実行することができます:

「+=」や「*=」のようないくつかの演算では、新しい行列を作成せずに、既存の配列を変更します。

型が異なる行列に対して演算する場合、演算結果の配列の型は、より一般度の高い型もしくはより精度の高い型(アップキャストとして知られている動作)になります。

配列に含まれる全要素の合計計算のような単項演算子の多くは、「ndarray」クラスのメソッドとして実装されています。

これらの演算子は、デフォルトでは配列の形状にかかわらず、数値のリストのように配列に適用されます。しかし、「axis」パラメータを指定することで、指定された配列の軸に沿って演算を実施することができます:

ユニバーサル関数

NumPyは、sin、cos、expのようなよく知られている数学関数も提供しています。NumPyでは、これらは「ユニバーサル関数(ufunc)」と呼ばれています。Numpyでは、これらの関数は配列の要素ごとに演算を行い、出力として新規の行列が作成されます。

関連項目

all, any, apply_along_axis, argmax, argmin, argsort, average, bincount, ceil, clip, conj, corrcoef, cov, cross, cumprod, cumsum, diff,dot, floor, inner, inv, lexsort, max, maximum, mean, median, min, minimum, nonzero, outer, prod, re, round, sort, std, sum, trace,transpose, var, vdot, vectorize, where

インデックス付け、スライス、イテレート

一次元配列に対しては、リストや他のPythonのシーケンスと同じように、インデックス付けやスライス、イテレートを行うことができます。

多次元配列は、軸ごとに一つのインデックスを持つことができます。これらのインデックスは、カンマ区切りのタプルで与えられます:

軸数より少ないインデックスが与えられた場合には、不足分のインデックスは完全なスライス「:」と見なされます。

「b[i]」の括弧の中の式は、残りの軸を表現するために必要な分の「:」で埋められているものとして扱われます。NumPyでは、これを「b[i,...]」のようにドットを用いて記述することもできます。

ドット「...」は、完全にインデックス付けされたタプルを生成するのに必要な分のコロンを表しています。例えば、「x」がランク5の配列(つまり5軸)の場合、以下の配列は等価になります。

- x[1,2,...]はx[1,2,:,:,:]

- x[...,3]はx[:,:,:,:,3]

- x[4,...,5,:]はx[4,:,:,5,:]

多次元配列に対するイテレートは、最初の軸に対して行われます:

一方で、配列の各要素に対して演算を行いたい場合には、配列の全要素に対して適用されるイテレータとなる「flat」属性を使用することができます:

関連項目

Indexing, Indexing (reference), newaxis, ndenumerate, indices

形状の操作

配列の形状の変更

配列は、各軸に沿った要素数によって与えられる形状を持ちます:

配列の形状は、様々なコマンドで変更することができます:

ravel()の結果として得られる配列の要素の順番は、通常は”Cスタイル”つまり一番右のインデックスが”最初の変わる”ので、a[0,0]の次の要素がa[0,1]になります。配列が別の形状に再整形されても、配列は"Cスタイル"として扱われます。NumPyは、通常はこの順番で格納される配列を作成するため、ravel()は普通は引数をコピーする必要がありませんが、配列が別の配列をスライスして作成されたり、一般的ではないオプションを使って作成された場合には、引数をコピーする必要があることがあります。ravel()とreshape() 関数 は、オプションの引数を使うことでFORTRANスタイルの配列、つまり一番左のインデックスが最初に変わるように指定することもできます。

reshape関数は、変更後の形状で引数を返す一方で、ndarray.resizeメソッドは配列そのものを変更します:

再整形の演算時に次元が-1で与えられた場合、他の次元は自動的に計算されます。

関連項目

ndarray.shape, reshape, resize, ravel

配列の積み上げ

複数の配列を、さまざまな軸に沿って積み上げることができます:

column_stack関数は、1次元配列を2次元配列に積み上げます。1次元配列の場合は、vstackと等価になります:

2次元以上の配列の場合には、hstackは2つ目の軸に沿って積み上げ、vstackは最初の軸に沿って積み上げます。concatenateは連結する軸の番号をオプションの引数として指定することができます。

注釈

複雑な場合においては、ある軸に沿って数字を積み上げることで配列を作成するr_とc_が役に立ちます。これは、範囲を表すリテラルである「:」を使うことができます:

配列を引数として使う場合、r_とc_はvstackとhstackのデフォルトの動作に似てますが、連結する軸の番号をオプションの引数として指定することができます。

関連項目

hstack, vstack, column_stack, concatenate, c_, r_

配列を複数の小さな配列に分割

hsplitを使用すると、同じ形状の配列を返す数を指定することで、もしくは分割させる後ろの列を指定することで、配列を水平軸に沿って分割することができます:

vsplitは垂直軸に沿って分割し、array_splitはどの軸に沿って分割するかを指定することができます。

コピーとビュー

配列の演算や操作時には、データを新しい配列にコピーする場合もありますし、コピーしない場合もあります。これは時として初心者を混乱させる元となります。これには3つのケースがあります:

コピー無し

単純な代入では、配列オブジェクトもデータもコピーされません。

Pythonは変更可能なオブジェクトを参照渡しするため、関数呼び出しではコピーは行いません。

ビューとシャローコピー

異なる配列オブジェクトが、同じデータを共有することができます。「view」メソッドは、同じデータを参照する新しい配列オブジェクトを作成します。

配列をスライスすると、ビューが返されます:

ディープコピー

「copy」メソッドは、配列とそのデータの完全なコピーを作ります。

関数とメソッド概要

ここでは、役に立つNumPyの関数とメソッドをカテゴリ順にリストします。完全なリストはhttps://docs.scipy.org/doc/numpy-dev/reference/routines.html#routinesを参照してください。

Array Creation

arange, array, copy, empty, empty_like, eye, fromfile, fromfunction, identity, linspace, logspace, mgrid, ogrid, ones, ones_like, r,zeros, zeros_like

Conversions

ndarray.astype, atleast_1d, atleast_2d, atleast_3d, mat

Manipulations

array_split, column_stack, concatenate, diagonal, dsplit, dstack, hsplit, hstack, ndarray.item, newaxis, ravel, repeat, reshape,resize, squeeze, swapaxes, take, transpose, vsplit, vstack

Questions

all, any, nonzero, where

Ordering

argmax, argmin, argsort, max, min, ptp, searchsorted, sort

Operations

choose, compress, cumprod, cumsum, inner, ndarray.fill, imag, prod, put, putmask, real, sum

Basic Statistics

cov, mean, std, var

Basic Linear Algebra

cross, dot, outer, linalg.svd, vdot

応用

ブロードキャストルール

ブロードキャストにより、ユニバーサル関数は、正確には同じ形状ではない入力でも意味のある方法で扱うことができます。

ブロードキャストの1つ目のルールは、すべての入力は配列が同じ次元数を持たない場合、すべての配列が同じ次元数を持つまで、配列の先頭に「1」を穴埋めするものです。

ブロードキャストの2つ目のルールでは、特定の次元に沿った大きさが1である配列は、その次元に沿って最大の形状を持つ配列の大きさを持つものとして振舞うことを保証します。配列の要素の値は、「ブロードキャスト」配列の次元に沿って同じ値であるとみなされます。

ブロードキャストルールが適用されると、すべての配列の大きさは一致することになります。詳細は https://docs.scipy.org/doc/numpy-dev/user/basics.broadcasting.htmlに記載されています。

役に立つインデックス付けとインデックスのコツ

NumPyは、通常のPythonシーケンスよりも多くのインデックス機能を提供しています。整数やスライスによるインデックス付けに加えて、これまでに見てきたように、整数配列やブーリアン配列でも配列にインデックス付けすることができます。

インデックス配列によるインデックス付け

インデックス配列「a」が多次元配列の時、単一配列のインデックスは「a」の最初の次元を参照します。以下の例は、ラベルの画像をパレットを用いてカラー画像に変換することでこの振る舞いを表します。

1次元以上の配列に対してインデックスを与えることもできます。各次元に対するインデックス配列は、同じ形状である必要があります。

通常は、「i」と「j」をシーケンス (つまりリスト) に入れて、リストでインデックス付けを行います。

しかし、「i」と「j」を配列に入れると、同じことはできません。なぜならこの配列は、「a」の最初の次元をインデックス付けするものとして解釈されるからです。

配列でインデックス付けする他のよくある使い方は、時間依存連続データの最大値検索です。

代入する対象として、配列でインデックス付けすることにも使用できます。

一方で、インデックスのリストに繰り返しが含まれている場合、代入は複数回行われ、最後の値が残ります:

これは十分に合理的なのですが、Pythonの「+=」構造を使いたいのであれば、期待している動作とは異なる場合があるので注意してください:

インデックスのリストに0が2回現れていますが、0番目の要素は1度しか増分されていません。これは、Pythonが「a+=1」を「a=a+1」と等価であるとしているためです。

ブール型配列によるインデックス付け

(整数の) インデックス配列で配列をインデックス付けする場合には、使用したいインデックスのリストを用意しています。ブール型インデックスを使う場合には、アプローチは異なります;使用したい配列の要素と使用したくない配列の要素を、明示的に選択します。

ブール型インデックス付けを検討する最もよくある方法は、元の配列と同じ形状を持つブール型配列を使うことです:

この性質は、代入のときに非常に便利です:

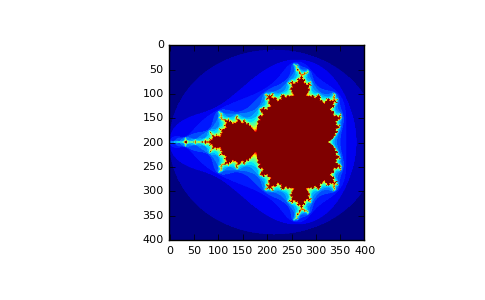

以下の例を見ると、「マンデルブロ集合」のイメージを生成するためにブール型インデックス付けをどのように使うかがわかります:

ブール型インデックス付けを使う2つ目の方法は、整数型インデックス付けにより似ています;配列の各次元に対して、欲しいスライスを選択して1次元のブール型配列を得ます。

1次元ブール型配列の長さはスライスしたい次元(もしくは軸)の長さと一致している必要があることに注意してください。前の例では、「b1」は長さが3 (「a」の行数) のランク1配列で、「b2」(長さが4) は「a」の2番目のランク(列)のインデックスに一致しています。

ix_()関数

「ix_」関数は、異なるベクトルを結合して各n-upletの結果を得るために使用することができます。例えば、ベクトルa、b、cから取得したすべての3つ組の値に対してa+b*cを計算したいのであれば:

以下のようにreduceを実装することもできます:

そして、このように使用します:

標準のufunc.reduceと比べたこのバージョンのreduceの利点は、出力xベクトル数の大きさの引数配列の作成を避けるために、ブロードキャストルールを使用するところにあります。

文字列によるインデックス付け

Recordarraysを参照してください。(参照先不明)

線形代数

執筆中です。基本的な線形代数がここに入ります。

簡単な配列演算

詳細はnumpyフォルダにあるlinalg.pyを参照してください。

ヒントとコツ

ここでは、ちょっとした役立つTipsを提供します。

「自動的な」再整形

配列の次元を変更する場合、配列のサイズを省略し、自動的に推定させることができます。

ベクトルの積み上げ

同じサイズを持つ行ベクトルのリストから、どのように2次元配列を作成するのでしょうか。MATLABでは、これは非常に簡単です:「x」と「y」が同じ長さを持つ2つのベクトルの場合、「m=[x;y]」とするだけです。NumPyでは、 積み上げを実行する次元に従って「column_stack」や「dstack」、「hstack」、「vstack」といった関数で実施します。例えば:

2次元以上でのこれらの関数のロジックは、奇妙ではあります。

関連項目

Numpy for Matlab users

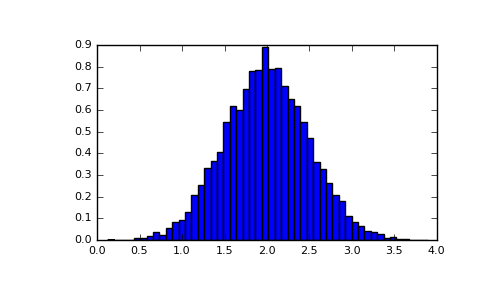

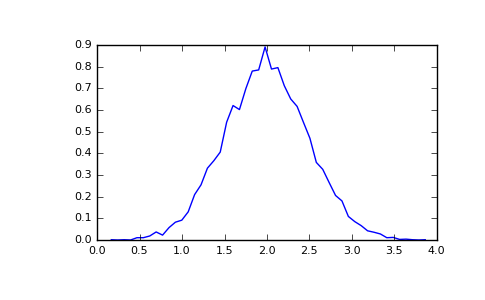

ヒストグラム

配列に適用されるNumPyの「histgram」関数は、ベクトルのペア、つまり配列のヒストグラムとビンのベクトルを返します。

注意:matplotlibにもヒストグラムを生成する関数 (Matlabでは「hist」と呼ばれます) がありますが、NumPyとは異なります。主な違いは、「pylab.hist」は自動的にヒストグラムを描画し、「numpy.histgram」はデータを生成するのみであることです。

参考情報

- Python tutorial

- NumPy Reference

- SciPy Tutorial

- SciPy Lecture Notes

- A matlab, R, IDL, NumPy/SciPy dictionary

データサイエンスにおけるETL vs ELT

ETLといえば、昔からBIの領域で様々なマスター/トランザクションデータを収集するために使われている技術です。すなわち、Extract (抽出) - Transform (変換) - Load (読み込み) という3つのプロセスで、BI側に役立つ形にデータを加工して取り込むことです。

これに対してELTという技術もあります。これはTransformとLoadの順番が逆のプロセスになっているもので、ETLアーキテクチャでは中間層がボトルネックになりやすいという問題を解消させる考え方です。例えばOracle社のData Integratorは、ELTアーキテクチャを採用してデータ変換をOracle Databaseのエンジン内で行うことにより、中間層がボトルネックになることを避けています。

このようにETLとELTという言葉はアーキテクチャの視点でのみ使われていると思っていたのですが、以下のブログから、データサイエンスの領域では異なった視点からELTという言葉が使われていることに気が付きました。

https://buckwoody.wordpress.com/2016/11/18/data-wrangling-elt-not-etl/

データサイエンスの目的は、BIのようにデータを可視化することではなくデータから答えを見つけ出すことにあるため、オリジナルのデータが非常に重要になります。このため、データ変換は最後にすべきことからETLプロセスではなくELTプロセスであるべきだということです。

機械学習のみでなく統計処理でもデータ処理のプロセスは確かにELTだったのですが、この言葉が使われているということには、うかつにも気が付きませんでした。

従来の統計処理と機械学習

最近様々な新聞や雑誌に、毎日のように機械学習(マシンラーニング)や深層学習(ディープラーニング)といった言葉がでてきますが、先日あるお客様より

「今までの統計処理と何が違うの?人工知能とはどう違うの?」

という質問をされました。

機械学習の使用してる数学的な手法やアルゴリズムは従来の統計処理(統計解析やデータマイニング)と非常に近いため、何が違うのかがよく分からないという人が多いような気がするので、このブログの最初のネタにしようと思います。

なおここで書いている内容は、あくまで解釈の一つとして理解ください。視点によっては違う解釈のほうが適合しやすいことがあります。

まず、

ではないですよね。機械学習や深層学習は、人工知能のための技術、もしくは研究テーマの一つであるという考え方です。

機械学習と深層学習についてですが、別々のもののように扱われている記事をよく見かけますが、深層学習は多層ニューラルネットワークを用いた機械学習の手法の一つです。ただし、深層学習は従来の機械学習の手法では難しかった画像、音声、言語を対象とする人工知能のテーマに対して優れた性能を発揮するため、独自のテーマとして脚光を浴びているという背景があるのだと思います。

ここまでで、先ほどのお客様からの質問に対して

「人工知能 ← (適用技術/研究テーマ) - 機械学習(深層学習含む)」

という回答になりました。

次に従来の統計処理との違いについてですが、先ほども書いたように機械学習と従来の統計処理の数学的な手法やアルゴリズムは非常に近いのですが、目的が異なります。つまり

- 統計解析は、まず仮説を立て、その仮説を標本データから推定、評価していくことで、仮説の正しさを検証するものです。つまり、データの意味や仮説を説明することに重きを置いています。

- データマイニングは、膨大なデータからルールやパターンを発見し、検証するものです。つまり事実の発見と説明に重きを置いています。

- 機械学習は、膨大なデータからルールやパターンを発見し、それを基に予測することを目的とするものです。つまり事実から予測をすることに重きを置いています。

なお、一般的に「予測」というと「未来を予測する」ことと思われますが、機械学習分野においては、「未来を予測する」ことだけではなく「見えないものを見えるようにする」ことにも予測という言葉を使います。例えばある企業が提供しているサービスを利用している顧客に対して、「3か月後にサービス利用を停止する顧客を予測する」ことも予測ですし、「今サービス利用を停止しようと考えている顧客を探し出す」ことも予測と言えます。

以上で、先ほどのお客様からの質問に対して、

「従来の統計処理との違いは目的」

という回答になりますね。

なお、別の解釈がある、こういう回答のほうがお客様が分かりやすい、という話がありましたら、是非ともコメント頂ければと思います。